Une anomie numérique en entreprise ?

Émile Durkheim, père fondateur de la sociologie, décrit l’anomie comme une situation où les normes sociales se brouillent ou disparaissent, provoquant désorientation, tensions, voire désengagement. Appliquée à l’usage de l’IA dans les organisations, cette notion éclaire une réalité actuelle : l’absence de cadre clair autour de l’IA génère du flou, des risques et une perte de repères collectifs.

L’IA, notamment via des outils accessibles comme ChatGPT, génère enthousiasme et exploration… mais souvent dans un vide normatif.

Résultat : des usages divergents, une gouvernance floue et un désalignement des valeurs internes.

Avec toutes les problématiques associées, notamment psychologiques et juridiques.

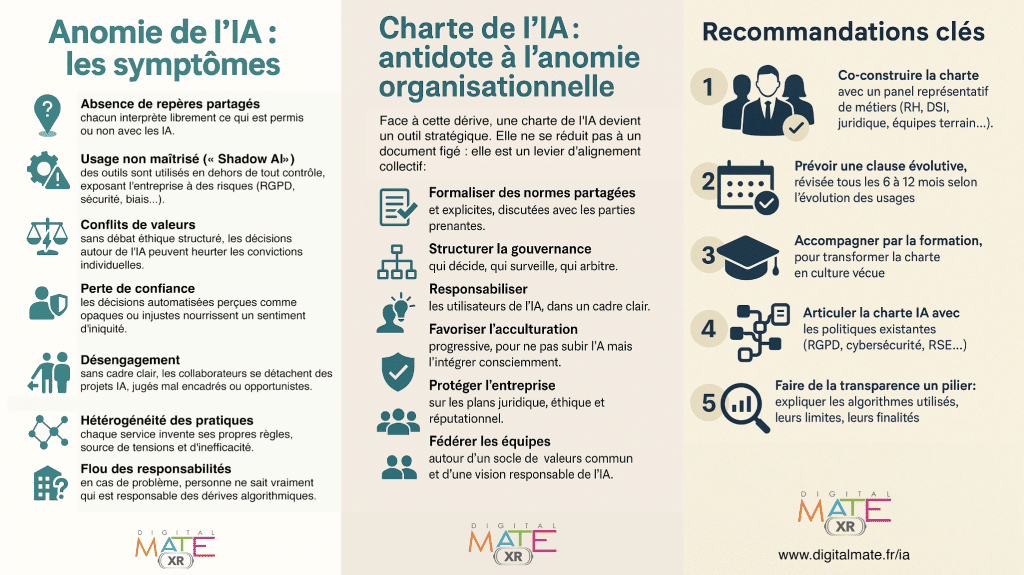

Les symptômes d’une anomie de l’IA en entreprise

Sans charte, plusieurs symptômes apparaissent, révélateurs d’un contexte anomique :

La charte IA : antidote à l’anomie organisationnelle

Face à cette dérive, une charte de l’IA devient un outil stratégique. Elle ne se réduit pas à un document figé : elle est un levier d’alignement collectif.

Elle permet de :

Recommandations clés